-

Pipeline : Définition, fonctionnement et utilité en Data Science

Un pipeline est un ensemble de processus et d’outils utilisés pour collecter des données brutes à partir de plusieurs sources, les analyser et présenter les résultats dans un format compréhensible. Les entreprises utilisent les pipelines de données pour répondre à des questions commerciales spécifiques et prendre des décisions stratégiques basées sur des données réelles. Tous les sets de données disponibles, (internes ou externes), sont analysés pour obtenir ces informations.

Lire la suite -

AI Hallucinations : Qu’est-ce qu’est ? Quelles conséquences ?

L’erreur est humaine, dit-on ! Mais pas seulement. Les machines intelligentes peuvent aussi se tromper. On parle alors d’hallucinations de l’AI. De quoi s’agit-il ? Quelles sont les causes ? Les conséquences ? Et surtout, comment prévenir les AI hallucinations ? Liora répond à vos questions.

Lire la suite -

Fonction Read_SQL sur Pandas : Comment ça fonctionne ?

Pour gérer et analyser les données fonctionnelles, les experts data peuvent utiliser une grande variété d’outils. Et notamment SQL ou Panda.

Lire la suite -

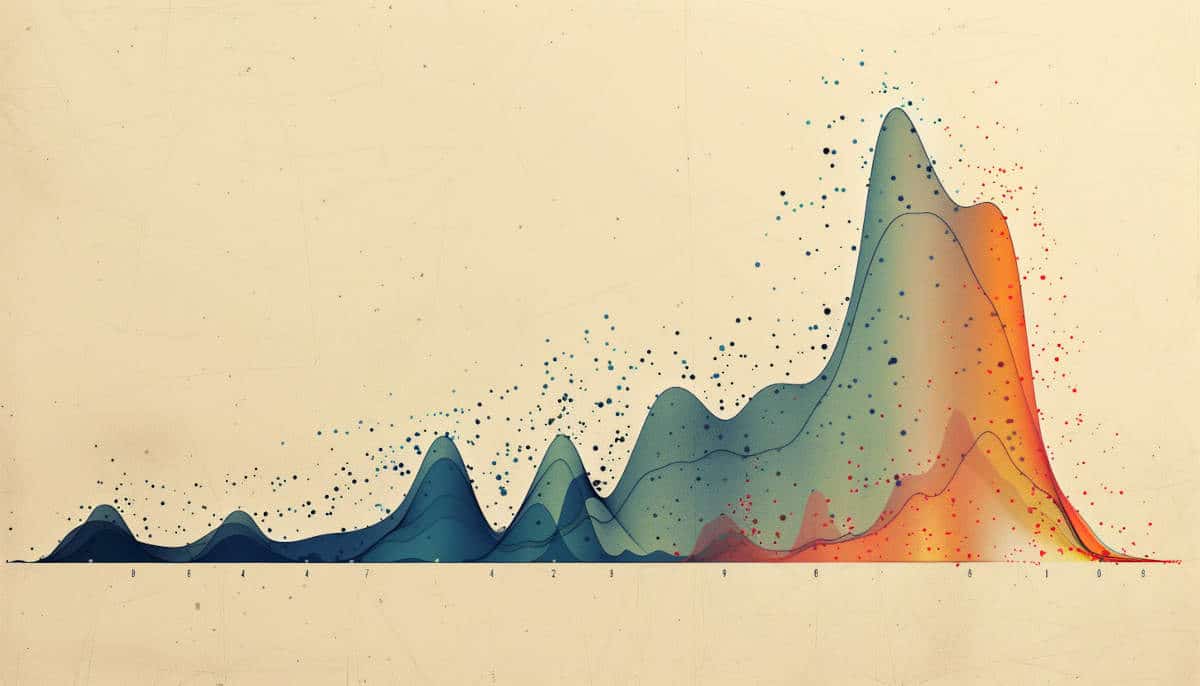

La loi de puissance : comprendre les relations entre les variables

Et si tout était lié ? Alors peut-être pas tout. Mais une grande partie des phénomènes naturels. C’est en tout cas ce que révèle la loi de puissance. Ce concept mathématique établit des relations dynamiques entre les variables qui ne suivent pourtant pas les mêmes modèles. Découvrez plus en détail cette loi.

Lire la suite -

PostgreSQL : Qu’est-ce que c’est ? Comment ça fonctionne ?

De nos jours, les besoins en stockage de données sont évolutifs et en constante croissance. Pour cela, plusieurs solutions de Système de Gestion de Base de Données (SGBD) existent. Certaines sont très populaires, comme MySQL, et d’autres solutions moins connues du grand public sont davantage prisées par les professionnels. C’est le cas de PostgreSQL, un système de gestion de base de données relationnelle orienté objet (SGBDRO), robuste, open source et capable de prendre en charge en toute fiabilité des gros volumes de données, en offrant des performances optimales.

Lire la suite -

TensorFlow : le framework de Machine Learning de Google

TensorFlow est un framework de Machine Learning créé par Google et disponible en open source. Découvrez tout ce que vous devez savoir à son sujet : histoire, fonctionnement, avantages, formations…

Lire la suite -

CRUD : définition, fonctionnement

Étroitement lié à la gestion de données numériques, le CRUD est un acronyme informatique anglais lié au fonctionnement des données stockées. Il englobe quatre opérations de base qui concernent la gestion de la pertinence des données et des applications : Create, Read, Update et Delete.

Lire la suite -

Cypher : le langage pour manipuler des données dans les graphes

Pour l’homme, la compréhension visuelle est souvent plus facile que la compréhension textuelle, car notre cerveau est capable de traiter les informations visuelles plus rapidement et plus efficacement. C’est pour cette raison que nous avons pu voir l’émergence des bases de données graphiques utilisant le langage Cypher au lieu du traditionnel SQL.

Lire la suite -

GPU : qu’est-ce que c’est et pourquoi l’utiliser en Data Science ?

Un GPU ou « Graphics Processing Unit » est le composant d’un ordinateur permettant l’affichage des images sur l’écran. Il s’agit de l’unité de traitement graphique.

Lire la suite -

Kibana : l’outil de visualisation des données indexées à Elasticsearch

Le back end est essentiel pour le développement web, mais aussi pour la Data. Dans cet article, nous allons partager avec vous tout ce qu’il faut savoir sur Kibana, notamment son fonctionnement dans Elasticsearch à travers ses fonctions les plus représentatives.

Lire la suite -

PyCaret : Tout ce qu’il faut savoir sur cette bibliothèque Python

Inspirée par un groupe de citoyens data scientists, Pycaret entend démocratiser le machine learning pour tous. Alors de quoi s’agit-il exactement ? Et surtout, quelles sont ses fonctionnalités ? C’est ce que nous allons voir dans cet article.

Lire la suite -

Séries temporelles : Daniel peux-tu nous en parler ?

Nouveau rendez-vous avec Daniel, le support technique des formations Liora. L’expert en data science qui accompagne les apprenants tout au long de leurs formations. Aujourd’hui, il nous parle des séries temporelles. Les séries temporelles constituent l’un des objets d’études les plus répandus de la science des données. Dans cet article, vous découvrirez les composantes principales d’une série temporelle.

Lire la suite

The newsletter of the future

Get a glimpse of the future straight to your inbox. Subscribe to discover tomorrow’s tech trends, exclusive tips, and offers just for our community.